1. 背景 (The Why)

作为一名网络安全从业者,我深知 AI 在未来攻防对抗中的重要性。为了验证“安全+AI”的融合场景,我决定在 Kali Linux 环境下,利用 Docker 容器化技术,私有化部署 Google 最新的 Gemma 模型,并搭建漏洞靶场进行联动测试。

2. 环境准备 (The Setup)

* 宿主机系统: Kali Linux 2024.4 (VMware)

* 核心工具: Docker, Ollama

* 目标模型: gemma3:1b (Google DeepMind 轻量级模型)

3. 实战过程与踩坑 (The Action)

Step 1: Docker 环境确认

首先检查 Docker 服务状态,确保容器环境正常。

docker ps -a

可以看到我本地已经运行了 medicean/vulapps 漏洞靶场,为后续 AI 安全测试做好了准备。

Step 2: 拉取 Ollama 镜像

使用 Docker 拉取 Ollama 官方镜像。

docker pull ollama/ollama

(这里曾遇到网络波动导致下载慢,通过配置镜像加速解决)

Step 3: 运行 Ollama 容器

启动容器并映射端口:

docker run -d -v ollama:/root/.ollama -p 11434:11434 –name ollama ollama/ollama

Step 4: 模型拉取与排错 (Troubleshooting)

在尝试拉取模型时,我遇到了 manifest not found 错误:

* ❌ 错误尝试:docker exec -it ollama ollama run gamma3:1b (拼写错误)

* ❌ 错误尝试:docker exec -it ollama ollama run llama3 (版本不对)

* ✅ 解决方案: 查阅官方文档,确认模型准确名称为 gemma3:1b。

* 成功命令:

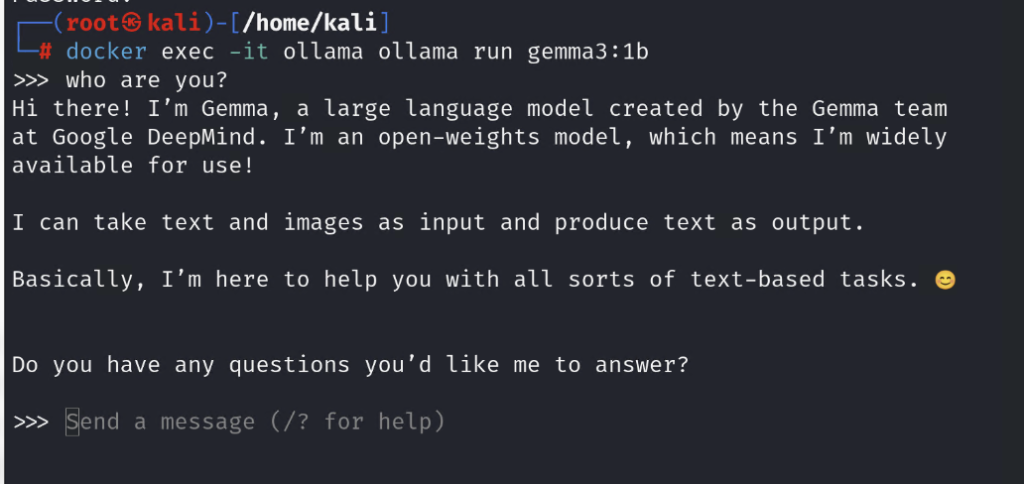

docker exec -it ollama ollama run gemma3:1b

4. 最终效果 (The Result)

成功进入交互式对话界面!

> User: “who are you?”

> Gemma: “Hi there! I’m Gemma, a large language model created by the Gemma team at Google DeepMind…”

>

5. 总结与思考

这次实战不仅跑通了 AI 私有化部署,更重要的是验证了 Docker 在 Linux 环境下的灵活性。下一步计划:

* 使用 Python 编写 API 接口调用该模型。

* 测试用 AI 生成 SQL 注入 Payload 并打向本地的 VulApps 靶场。